AI 大模型的下一步,或许是 Google 早年的那种便宜的方案

来源:王建硕

作者:王建硕

Google 早期的服务器的样子,这么多年在我脑子里,一直挥之不去,成为我对技术,对创业公司的理解的一个基准。

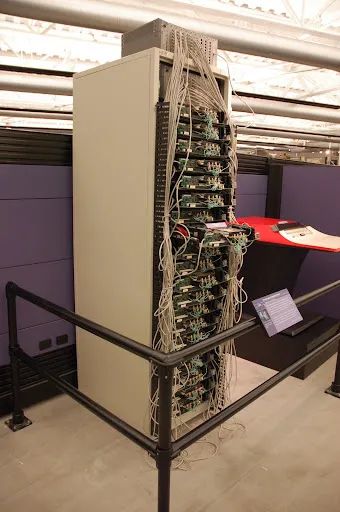

这是 2007 年,我在硅谷的计算机博物馆看到的一台:

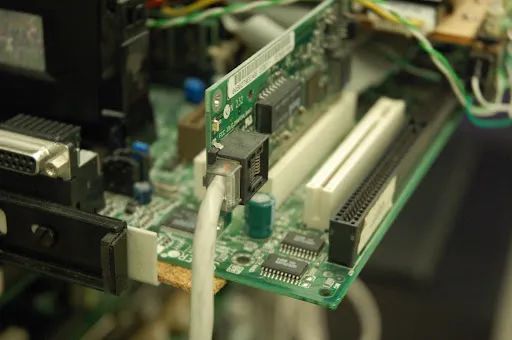

下面的照片里面,绿色和白色相间的一条是 reset 的线,连着一个按钮,一条是普通 PC 的硬盘灯。四个这样按钮和灯用四个螺丝钉直接固定在一个硬纸板上面。

显卡的位置什么也没有插,其他的扩展槽也都空着。

只有一个网卡,和网线。

CPU是奔二的。

这个是整个主板的样子。

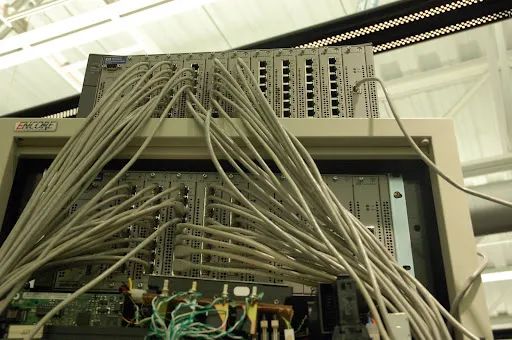

这个惠普的 Switch 总共有80条进线。

这一个机柜,总共是20层。每一层的架子上面垫着一层松木板的隔层,隔层上面放四个一摸一样的主版,四块硬盘放在中间一条。

还有一台现存的在 Google 的访客中心。

在互联网初期,非常快,搜索就成为一个有用,有前途的事情。那个时候垄断的搜索引擎是 Lycos,AltaVista,InfoSeek 等等,像极了最近的各个大模型公司群雄争霸。

但是和现在的大模型公司类似的是,这些搜索公司用的是 Sun Microsystem 的系统,用的是 HP 等高端的服务器,稳定性一流,成本也惊人。当时运行搜索引擎可是个花大钱的生意。随着流量的不断攀升,成本也惊人的攀升。同时受到算力的限制,他们的搜索还是基本的检索,就是文字的反向索引表,搜索效果一般。

Google 最初想到了 PageRank 算法,就是根据其他网页的链接的权重来算网页的重要度。这个倒是一个不错的想法,但是实现起来需要非常大的算力,这个过程基本上和现在的大模型算文字的向量有点像。我想知道一个网页的权重,我就需要把全网看一遍,看哪些其他的网页指向这个网页,以及这些网页的权重,而这些网页的权重又要这样的逻辑算一遍,几乎是一个死循环一样的算力要求。

Google 的解决方案,就没有买当时唯一正确的主机厂商动辄几万美金一台的高端服务器,而就是在一张软木纸上,放上四小片主板,然后绑上硬盘,插上网卡,就结束了。

很显然这样的稳定性和厂商的主机相比是天壤之别。所以,Google 就用软件,做了Google File System 分布的文件系统,让文件在多个地方重复写入,任何硬件坏了,数据就立刻可以在其他地方重建,以至于你冲过去随便砸坏几个「小电脑」都不影响。在加上自己的 MapReduce 的框架,把计算可以分布(map)在这些小电脑上计算,然后把结果汇总(Reduce),就可以把这么多电脑的算力加在一起,而不用一台或几台特别强大的电脑。

总之,经过这么一番折腾,Google 因为硬件便宜,算力足,存储便宜,这些才足以支撑 PageRank 这样的巨大的算力消耗,非常快就从 Stanford 的一个无名的小站,打败了当时的巨头,成为了今天的 Google。所以,从某种角度说,用软件换来的硬件的巨大的成本优势,是 Google 早期成功不可忽略的因素。

这段历史,是不是会对现在的 AI 格局有所启发呢?

用 Nvdia V100 的显卡堆出来的 OpenAI 的 ChatGPT 的模型,固然帮助我们完成了从没有到有,从看不到可能性到证明了可能性的第一步,就如同 Lycos 搭起来的昂贵的搜索引擎服务一样。但,是不是有 Google 这样的方式,用软件的方式疯狂的降低硬件成本的可能性呢?当然我们已经过了手工攒服务器的时代了,用电烙铁焊 GPU 似乎也不是靠谱的路子(Google 当年也用没有这么做,而是直接用的 Intel 奔腾II 的 CPU ),但是会不会有一些让人拍案叫绝的方案,可以大规模的降低成本呢?

我不是做大模型的, 并想不出来什么方案。但如果这样的方案存在,或许将极大的改变大模型行业的竞争壁格局。